Mientras la sociedad civil brasileña celebra por segunda vez el #Criptoagosto, una invitación a defender y promover el uso de las tecnologías de cifrado, parece ser que las figuras del poder hacen un esfuerzo significativo por atacarlo.

¿De dónde nacen todas estas amenazas? Si revisamos noticias, vemos que la pugna ocurre paralelamente ante tribunales, en la discusión legislativa, en la pretensión de vigilancia y hasta en los planes comerciales globales de un fabricante de teléfonos a sobreprecio.

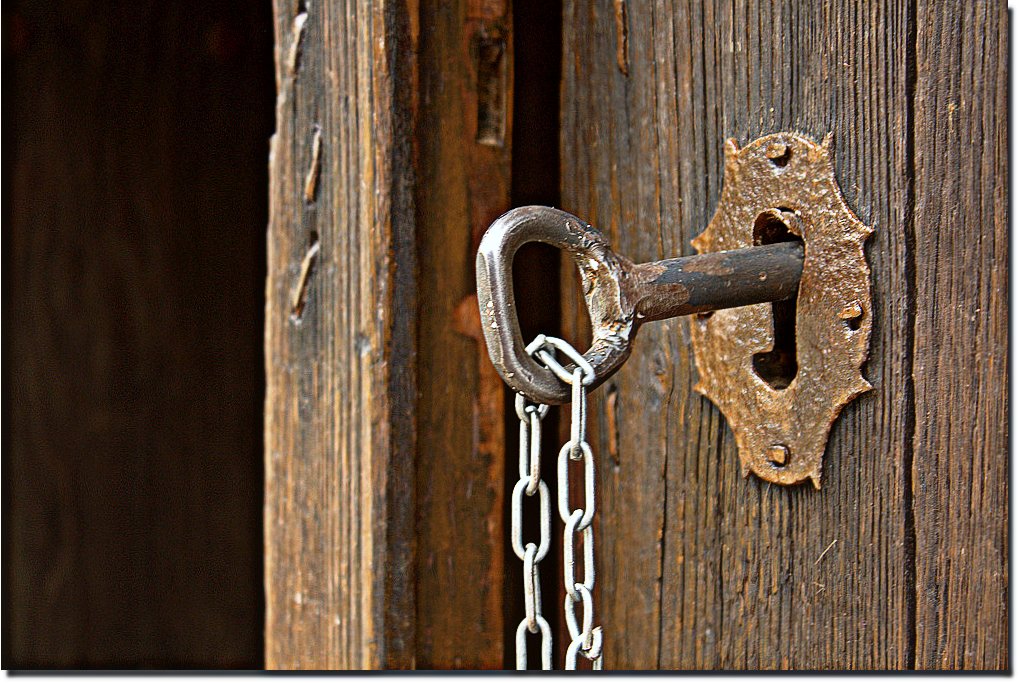

Hace un año comentábamos que se acercaba el fin de dos importantísimas causas judiciales críticas para la supervivencia de comunicaciones cifradas de punto a punto, pese a los discursos gubernamentales que lo asocian a la actividad criminal o exigen herramientas para desactivarlo. Existen todavía esfuerzos legislativos en Brasil, a nivel federal, que reflejan ese discurso a favor de la seguridad nacional o del orden público, a costa de la seguridad de las comunicaciones.

Al mismo tiempo, se mantenía una presión importante por desactivar las peores provisiones del proyecto de «Ley de fake news», que exigían la trazabilidad de las fuentes de los mensajes vitalizados en mensajería privada, aun tratándose de comunicaciones cifradas. Esta última amenaza no ha desaparecido: el artículo 10 de la propuesta aún significaría la exigencia de que los proveedores de aplicaciones de mensajería mantengan registros de «reenvíos masivos» de mensajes por tres meses, con el fin de trazar el origen de posibles fuentes de desinformación en redes de mensajes cifrados. Registros que incluirían no solo datos del mensaje, sino de quienes lo han reenviado con fecha y hora y número de receptoras.

Aunque el proyecto mantiene resguardos a favor del contenido de los mensajes y restricciones al acceso a los registros, sigue tratándose de un arma de vigilancia masiva en manos privadas: implica mantener un registro de los reenvíos al menos por 15 días en caso de que puedan convertirse en «reenvíos masivos» y, si lo son, cada mensaje registrado estará vinculado a cada usuaria que lo haya enviado o recibido. Con ese nivel de acceso a la información sobre la circulación del mensaje, el cifrado mismo se vuelve inútil.

Adicionalmente, encontramos el avance del Código de Procedimiento Penal, también objeto de atención de la sociedad civil para asegurar una mejor protección de los derechos fundamentales en la persecución criminal. La amenaza al cifrado se produjo mediante propuestas para incorporar mecanismos de intercepción de dispositivos y la explotación de vulnerabilidades, como medios para generar evidencia, lo que generó inmediato rechazo: la reforma amenazaba así con requerir la creación de puertas traseras y con legalizar la rotura del cifrado.

Aun cuando todo lo anterior estuviera restringido al debate jurídico y técnico, los intentos reales por comprometer la seguridad de los equipos también son parte de la historia reciente: hace algunos años el Citizen Lab identificó a Brasil como posible cliente de NSO Group; ahora un reporte señala que durante 2021 la empresa israelí participó de un proceso de licitación del Ministerio de Justicia y Seguridad Pública para la adquisición de Pegasus, para luego retirarse cuando se reportó que el hijo del presidente intervino en la negociación con la aparente intención de crear un aparato de inteligencia (y de vigilancia) paralelo a la institucionalidad de inteligencia actual.

Todo eso ocurre en momentos en que la búsqueda de alternativas —es decir, puertas traseras—para el acceso a comunicaciones y datos cifrados es defendida por las propias compañías fabricantes de equipos, con el objetivo loable de prevenir la circulación de material audiovisual de abuso sexual infantil. Pero las puertas traseras no sirven: comprometen la privacidad y la seguridad de todas las personas sin hacerse cargo del abuso real que ocurre más allá de pantallas y nubes de almacenamiento. Esta es la clase de medidas que abre aún más el apetito de los Estados por conocer el contenido de las comunicaciones de las personas, probablemente bajo los mismos discursos falaces sobre seguridad que se usan hasta para las peores conductas de vigilancia.

Con un panorama global tan complejo y tantas discusiones en curso dentro de Brasil, se hace más necesario que nunca que en los niveles local, regional y global exista mayor coordinación, no solamente de sociedad civil, sino de todas las partes interesadas en la promoción y la defensa del cifrado, la seguridad y la privacidad. Que el #CriptoAgosto brasileño sirva como motivación para avanzar en ello.