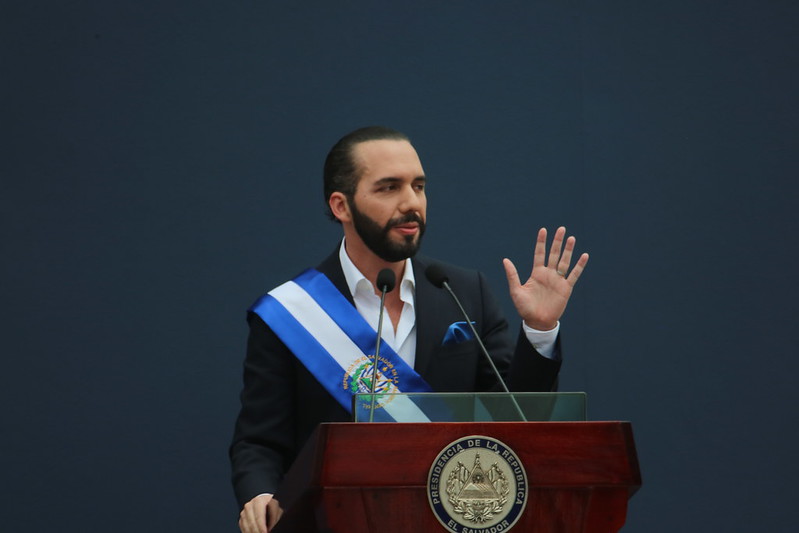

Algunos ejemplos como la toma del Instituto de Acceso a la Información Pública (IAIP) volviéndolo una institución irrelevante; la destitución ilegal de los 5 magistrados de la Sala de lo Constitucional y del Fiscal General, sustituidos también de manera ilegal por abogados leales a Bukele; así como la remoción de jueces incomodos al oficialismo, son solo parte de esta ofensiva que busca socavar los controles inter orgánicos, que en el fondo pretenden, según algunos analistas, proteger a su círculo de los señalamientos de corrupción que pesan sobre su gestión.

En este afán de disolver los controles sobre su administración, Bukele también finalizó abruptamente el convenio con la Comisión contra la Corrupción y la Impunidad en El Salvador (CICIES) que él mismo había instaurado y su Fiscal impuesto, disolvió la Unidad Anticorrupción de la Fiscalía General de la República (FGR) cuando se hizo público que investigaban algunos de los múltiples señalamientos de corrupción en el manejo de los fondos destinados para el combate a la pandemia, así como el pacto con la pandilla MS13.

Todo quien contradice a Bukele es un enemigo

Una de las principales características de Bukele y su maquinaria de propaganda es su desprecio por todo aquello que implique control y críticas a su gestión. Periodistas, académicos, universidades, organizaciones de la sociedad civil (OSC), defensores de derechos humanos, miembros de partidos políticos de oposición, etc., han sido víctimas, la mayoría de veces, de acoso digital. En otras, de persecución por parte de las instituciones que son usadas para acallar las voces disonantes.

El caso de Mario Gómez, detenido arbitrariamente por la Policía Nacional Civil (PNC) luego de manifestar críticas a la implementación del Bitcoin como moneda de curso legal; la violación a derechos humanos de personas encarceladas, llevada a cabo por la Dirección de Centros Penales contra el ex Alcalde de San Salvador, del partido Alianza Republicana Nacionalista (ARENA) y contra ex funcionarios de gobiernos del Frente Farabundo Martí para la Liberación Nacional (FMLN); la investigación abierta por el Fiscal impuesto a fiscales que formaron parte de la Unidad Anticorrupción de la FGR —que era liderada por el ex fiscal German Arriaza, hoy exiliado— son muestras de lo peligroso que se está volviendo el clima en El Salvador en lo referente al respeto a los Derechos Humanos en general y, en particular, al derecho a la libertad de expresión.

A estas acciones se suman dos casos más que retratan la naturaleza del régimen de Bukele en cuanto a la persecución de quienes considera sus “enemigos”: 1) la intención de aprobar una Ley de Agentes Extranjeros, por la cual se pretendía retener el 40% de cada transacción que recibieran las OSC y medios de comunicación, desde el exterior; y, 2) el caso del espionaje con el software Pegasus, realizado a por lo menos, 35 periodistas y miembros de OSC, recién hecho público.

Si bien la aprobación de Ley de Agentes Extranjeros fue detenida a raíz de las múltiples críticas que recibió, que incluyeron un llamado de la CIDH y la RELE para que el Estado salvadoreño se abstuviera de aprobarla, la intención de darle vida aún no ha sido descartada totalmente.

En el caso del espionaje con Pegasus, el informe que corrobora la existencia de la vigilancia con dicho software destaca que la infección ha sido especialmente insistente, con numerosos y prolongados accesos a algunos de los dispositivos intervenidos. Estas infecciones coinciden con los momentos en los que las víctimas de espionaje reporteaban sobre temas delicados que involucraban a la administración Bukele, como el caso del pacto con la pandilla MS-13 en el que esta se comprometía a reducir los homicidios a cambio de dar apoyo electoral a Bukele.

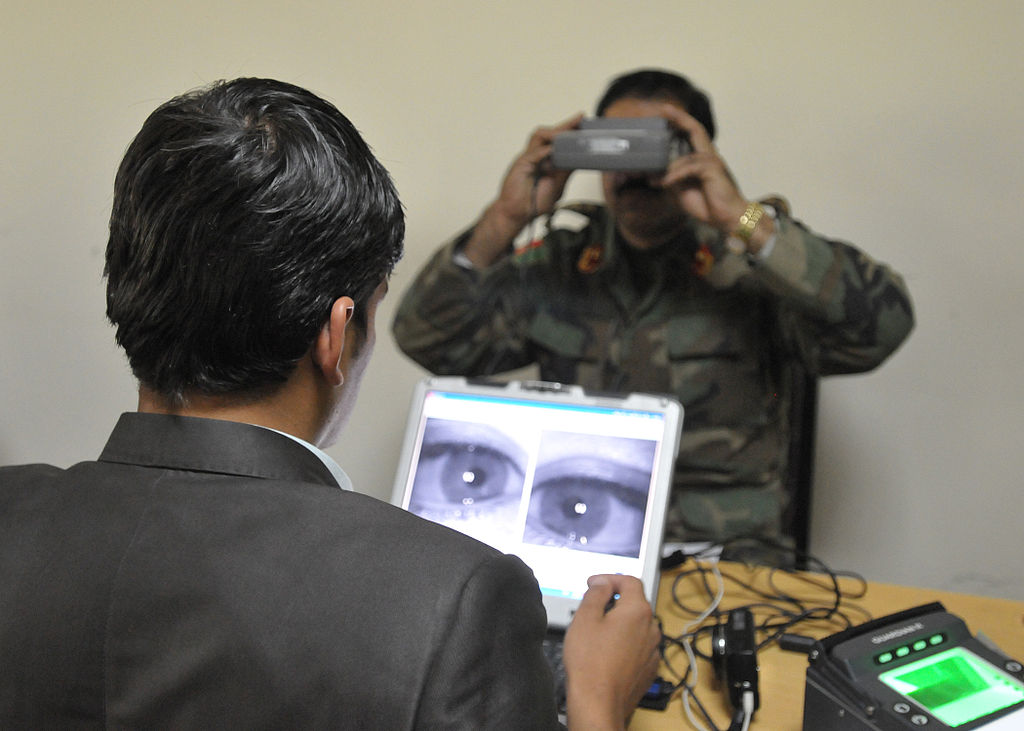

Aunque el gobierno ha intentado desligarse de este ataque, parte del informe señala que, si bien es cierto no ha podido establecerse el vínculo entre una infección particular con un usuario específico de Pegasus, si ha podido identificarse a un usuario que opera casi exclusivamente en El Salvador desde noviembre de 2019, el cual ha sido identificado como Torogoz.

Con todo este contexto, no es descabellado las pronunciaciones de alerta cuando son presentadas iniciativas de ley desde el Ejecutivo, como las reformas a la Ley de Delitos Informáticos y Conexos (LDIC) y al Código Procesal Penal (CPP).

En las reformas a la LDIC, que han sido aprobadas por la Asamblea Legislativa, pero aún no sancionadas por el Presidente, se reformó el art. 25 que penaliza la obtención y transferencia de información confidencial por medio de las tecnologías de la información, en un sentido distinto al articulado antes vigente. Mientras que la ley del año 2016 señalaba que la información obtenida de manera ilegal debería servir para vulnerar un sistema o datos informáticos, la actual reforma únicamente contempla el hecho de obtener o transferir información confidencial, eliminando el otro requisito del tipo penal: la vulneración de un sistema con esa información.

En un contexto en el que las instituciones públicas abusan de la declaratoria de reserva que la Ley de Acceso a la Información Pública (LAIP) permite, la obtención de información pública que a veces incluye información que debería ser oficiosa, se logra a través de fuentes que deciden colaborar con periodistas. Por ejemplo, el artículo en cuestión más parece ser una medida de disuasión para que las fuentes se abstengan de seguir dando información y que los/as periodistas se abstengan de publicar información obtenida en contra de este artículo. Esto constituye una clara violación al derecho de acceso a la información, en tanto que todas las vías información sobre la gestión gubernamental están siendo cerradas de manera acelerada.

Por su parte, en las reformas al CPP se contempla la inclusión de la “evidencia digital” que genera muchas dudas, principalmente sobre la autoridad responsable para autorizar y monitorear la operatividad del “agente digital encubierto”. También se cuestiona la forma en la que, para dar validez a la evidencia obtenida en la intervención de dispositivos tecnológicos en la investigación de un delito, no se requiere que quien intervenga el aparato sea un perito. Otro de los cuestionamientos tiene que ver con las medidas cautelares, que incluyen el bloqueo de cuentas, perfiles o sitios web que se estén investigando por algún delito.

A primera vista, preocupa la falta de referencia en el texto de la reforma a la idoneidad y proporcionalidad de este tipo de medidas propuestas. Sin embargo, uno de los temores más acuciantes es el contexto en el que se están proponiendo estas medidas: el de un gobierno que está intentando, por todos los medios, restringir el derecho de acceso a la información pública, esencial para el control ciudadano, y que, en el camino, tampoco tiene reparo en vulnerar la privacidad de sus ciudadanos/as.

En el marco de la derogatoria de la celebración de los Acuerdos de Paz, que puso fin al conflicto armado del país, los temores sobre la deriva autoritaria del régimen de los Bukele continúan haciéndose realidad a pasos agigantados.