Ha pasado medio año desde la última vez que observamos lo que ocurre en América Latina en materia de regulación de inteligencia artificial. Al igual que las tecnologías, que se expanden, desarrollan y se popularizan, aunque no a la misma velocidad, las regulaciones en la región también han progresado. Como es esperable, no se trata de sucesos aislados en el mundo, sino parte de una tendencia global que ya tiene algunos hitos significativos en el primer mundo, que amenazan con convertirse en modelos para realidades muy distintas.

Europa: ¿modelos a seguir?

A mediados de mayo, el Consejo de Europa adoptó el primer tratado internacional sobre inteligencia artificial, marcando un hito significativo en la regulación de esta tecnología emergente.

El Convenio establece requisitos de transparencia y supervisión adaptados a riesgos específicos, incluyendo la identificación de contenidos generados por IA. Las partes deben identificar, evaluar, prevenir y mitigar riesgos, y considerar moratorias o prohibiciones si la IA es incompatible con los derechos humanos. También se garantiza la rendición de cuentas y el respeto a la igualdad y la privacidad. Además, deben asegurar recursos legales y garantías procesales para las víctimas de violaciones de derechos humanos e informar a quienes interactúan con estos sistemas. El tratado requiere medidas para que la IA no socave las instituciones democráticas. El convenio incluye un mecanismo de seguimiento mediante una Conferencia de las Partes y exige un mecanismo de supervisión independiente, sensibilización pública y consultas con múltiples partes interesadas.

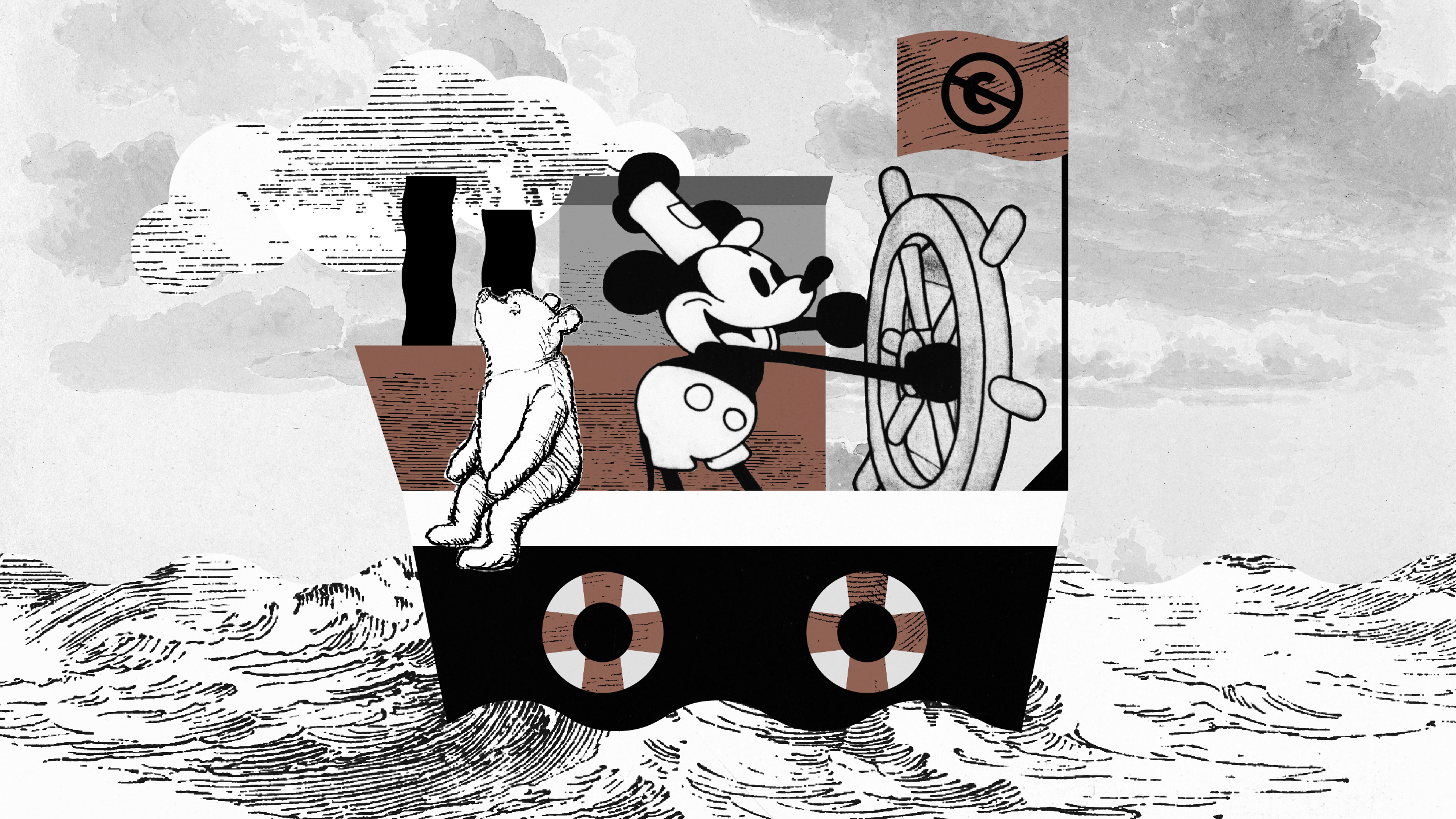

En tanto, después de una larga y tensa negociación, en marzo el Parlamento Europeo aprobó una ley histórica para regular la inteligencia artificial en la Unión Europea, en un movimiento pionero a nivel global. Este acto legislativo, conocido como la Ley de Inteligencia Artificial o «AI Act», tiene como objetivo establecer un marco regulatorio robusto para la inteligencia artificial, abordando preocupaciones tanto de innovación como de ética y derechos.

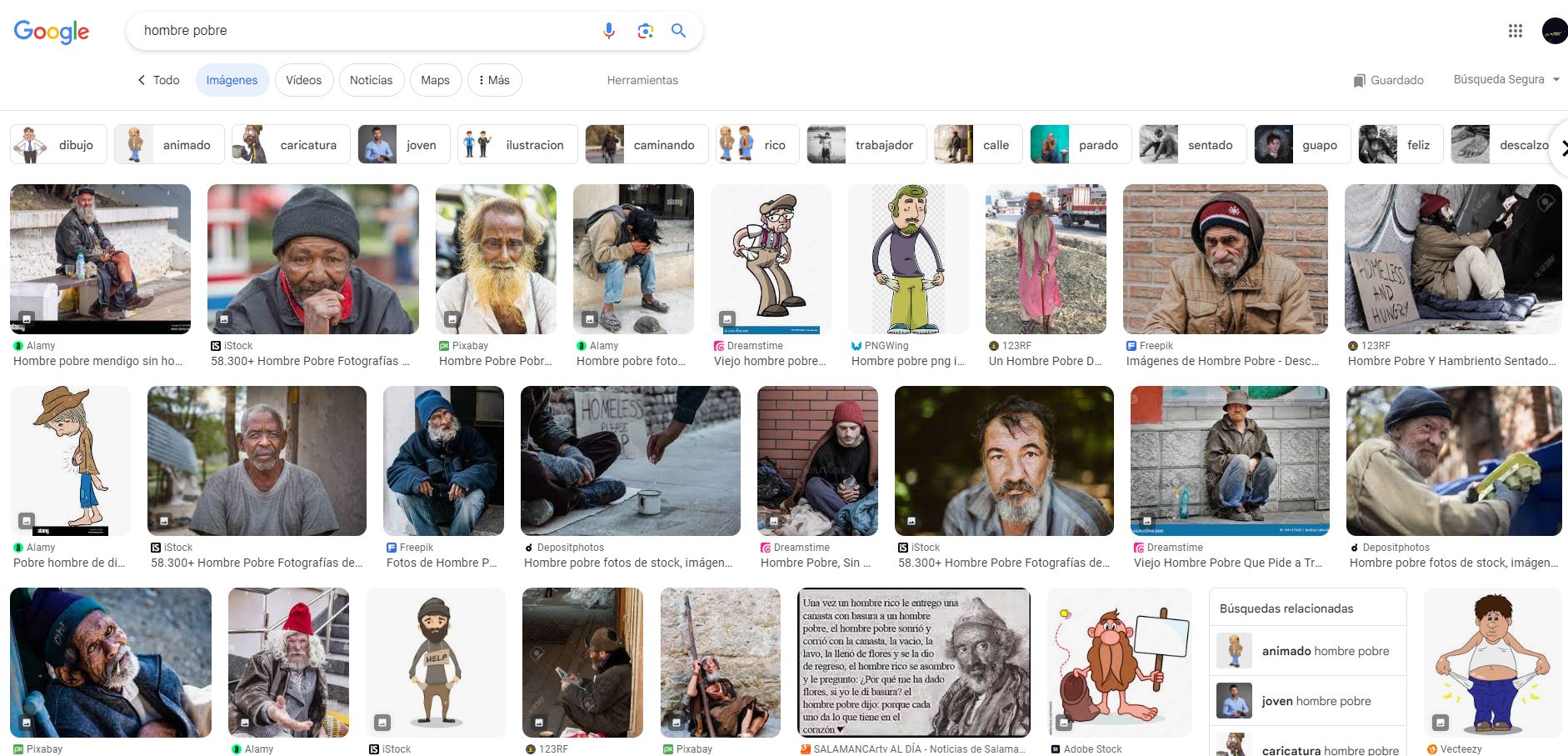

La nueva reglamentación prohíbe ciertas aplicaciones de inteligencia artificial que violan los derechos ciudadanos, como sistemas biométricos invasivos y la creación de bases de datos de reconocimiento facial mediante la captura indiscriminada de imágenes. Además, los sistemas de IA de alto riesgo deben evaluar y mitigar riesgos, ser transparentes y sujetos a supervisión humana.

Sin embargo, no todo es celebración. Críticas desde la sociedad civil han dado cuenta de que la AI Act está llena de vacíos legales y defectos que podrían socavar su eficacia en la protección del espacio cívico y el Estado de derecho. En particular, se han destacado fallas, excepciones y vacíos que podrían convertir las prohibiciones contenidas en la Ley en meras declaraciones vacías, sin efecto real.

América Latina y los “nuevos” modelos

Volviendo a la realidad regional, ha sido medio año de interesantes y preocupantes sucesos. Algunas de las propuestas que ya hemos mencionado han seguido su curso, con la continuación de la discusión en Brasil y una propuesta de reemplazo en Costa Rica, que simplifica y mantiene la propuesta más bien como un proyecto marco. Más de un proyecto en Argentina y alguno en México dan cuenta de la tendencia a presentar iniciativas, con muy variables contenidos y perspectivas de convertirse en ley.

Otros han avanzado más. El Perú, ejemplo de la primera ley sobre inteligencia artificial en la región a mediados de 2023, de limitado alcance por sí sola, ha visto recientemente la publicación de un reglamento para la ley, sometido a comentarios públicos. El especialista Carlos Guerrero destacaba las carencias técnicas de la propuesta reglamentaria, dando cuenta de las dificultades prácticas en la implementación de medidas que hagan efectivas las obligaciones asociadas al desarrollo de la IA.

En Colombia, en tanto, logró algo de tracción un proyecto de ley, originado en la Cámara de Representantes para regular la inteligencia artificial. En audiencia ante la Comisión primera, la Fundación Karisma destacó la necesidad de mejor comprensión del panorama antes de regular, como también la conveniencia de una mayor interacción con distintas partes interesadas, en línea con su profundo llamado a la participación ciudadana en estos procesos. Por cierto, un llamado que vale la pena reforzar frente a la serie de proyectos de ley sobre IA que han proliferado también en el Senado.

En Chile, en tanto, después de un proyecto de ley de la Cámara que había encontrado críticas y resistencia, el Ejecutivo envió su propio proyecto de ley de regulación integral de la inteligencia artificial, suscrito por once ministerios. El proyecto define los sistemas de IA de manera amplia para aplicar sus obligaciones a proveedores, implementadores, importadores, distribuidores y representantes autorizados en el país, definiendo distintos roles en la cadena de suministro de IA y centrándose más en el uso que en tecnologías específicas.

En comparación con la legislación de la Unión Europea y la regulación de los Estados Unidos, el proyecto establece un enfoque reactivo en lugar de preventivo. Se clasifican los sistemas de IA en categorías de riesgo, desde inaceptable hasta sin riesgo evidente, y se aplican prohibiciones y reglas específicas para cada categoría, incluyendo casos como la prohibición de análisis biométrico en tiempo real en espacios públicos. Se promueve la autorregulación de las empresas en la evaluación, de manera que cada empresa clasifique el riesgo de sus sistemas en base al listado que elabore un nuevo Consejo Asesor de IA.

El proyecto incluye medidas para incentivar la innovación, especialmente entre las pymes y las startups. Se proponen sandboxes regulatorios, como espacios de pruebas y validación para sistemas de IA, gestionados por entidades públicas como la eventual Agencia de Protección de Datos Personales. El Consejo Asesor de IA tendría así un papel clave en la identificación de sistemas de alto riesgo y limitado riesgo, así como en la elaboración de normativas. La eventual Agencia también tendría responsabilidad en la supervisión y aplicación de la ley.

Si bien buena parte del proyecto chileno suena heredado de otros esfuerzos como la AI Act, el gobierno chileno ha reconocido que tanto los intereses económicos como la seguridad pública son factores clave en la aproximación a la adaptación local. Esto es causal de alarma: aunque hay un criterio pragmático en no fijar obligaciones estrictas previas al funcionamiento en un mercado reducido como el chileno, se abandona una aproximación precautoria de derechos fundamentales. El problema se exacerba al notar la excepción a las reglas de la ley que se extiende, de manera general, a la seguridad nacional, y separadamente, a la aplicación en la seguridad pública para usos tales como el reconocimiento facial automatizado. Así, la oportunidad de una moratoria protectora de derechos no solo es desaprovechada, sino expresamente rechazada.

Las disputas que vienen

A medida que la regulación de la inteligencia artificial avanza en América Latina, surgen preocupaciones sobre la protección de los derechos fundamentales. La excepción a las reglas de la ley para la seguridad nacional y la falta de participación cívica en la implementación y supervisión podrían debilitar la capacidad de la regulación para salvaguardar los derechos de los ciudadanos.

Es fundamental trabajar en la promoción de regulaciones que fomenten la transparencia, la rendición de cuentas y la participación ciudadana en la toma de decisiones sobre el desarrollo y uso de esta tecnología emergente, con el objetivo de garantizar un equilibrio adecuado entre la innovación tecnológica y la protección de los derechos humanos. Derechos Digitales se encargará de participar activamente en las discusiones legislativas relacionadas con la inteligencia artificial, por lo que puedes esperar análisis más detallados sobre varias de estas propuestas.