Temática: Libertad de expresión

Autoritarismo, censura y libertad de expresión en internet

En febrero de 2020, cuando el presidente Nayib Bukele irrumpió con militares en el Salón Azul de la Asamblea Legislativa para presionar la aprobación de un millonario préstamo, las señales sobre el carácter autoritario del mandatario no han hecho más que incrementarse.

En este camino, el mandatario desobedeció sentencias de la Sala de lo Constitucional y se aseguró de debilitar progresivamente el Instituto de Acceso a la Información Pública (IAIP) hasta tomarlo por completo y volverlo un ente sin incidencia alguna. Sumado al debilitamiento institucional, hostigó y acosó a periodistas, defensores de derechos humanos y críticos a su gobierno, con complicidad de funcionarios reforzadas por apoyos a través de redes sociales. Estas últimas acciones, que aún continúan, han ocasionado que la Comisión Interamericana de Derechos Humanos (CIDH) ordene al Estado la protección de periodistas del periódico digital El Faro y de la abogada Bertha de León, por considerar que la integridad física de los amparados corre peligro.

Finalmente, en mayo de 2021, la Asamblea Legislativa —de mayoría oficialista— en su primera sesión destituyó ilegalmente a los cinco magistrados de la Sala de lo Constitucional y llenó sus vacantes en contra de los procedimientos establecidos por la Constitución. Igual suerte corrió el Fiscal General.

Para completar el golpe al Órgano Judicial iniciado en mayo, la Asamblea Legislativa aprobó el Decreto Legislativo Nro. 144 que jubila a jueces y magistrados de cámara mayores de 60 años o con 30 años de servicio que representan un tercio de los jueces del país. La decisión fue realizada sin tener competencia de acuerdo a la Constitución, lo que ha sido interpretado como un pretexto para dar a la Corte Suprema de Justicia —hoy tomada por el oficialismo— mayor margen de maniobra para remover jueces y sustituirlos con juzgadores afines.

Paralelo a la remoción de jueces, la Sala de lo Constitucional impuesta por el oficialismo emitió una resolución que autoriza al presidente Bukele a ser relecto en su cargo, a pesar de la prohibición que la misma Constitución establece.

La marcha del 15 de septiembre y la libertad de expresión

En este contexto de eliminación del sistema de pesos y contrapesos, más el descontento generado por la aprobación inconsulta de la ley que obliga al uso del Bitcoin como moneda de curso legal, el actual gobierno enfrentó la primera marcha multitudinaria en su contra, realizada por la sociedad civil el pasado 15 de septiembre.

En el marco de esta protesta, el hashtag #El15marchamos fue posicionado para acompañar los reclamos en el ámbito digital. Paralelamente, algunos usuarios organizaron spaces en Twitter para informar e intercambiar opiniones sobre estos temas relevantes.

En días posteriores a la realización de la marcha, usuarios de Twitter denunciaron la “desaparición” fulminante del #El15marchamos que, hasta unas horas antes y por varios días, había estado como tendencia en la red social. Al mismo tiempo, algunos organizadores de spaces denunciaron que estas sesiones terminaban abruptamente, sin haber sido notificados de las razones por las cuales esto sucedía.

La hipótesis para explicar estos hechos fue que tanto el hashtag como las cuentas organizadoras de los spaces estaban siendo denunciadas por cuentas afines al oficialismo. Dicha hipótesis se alimenta por la confesión del Ministro de Seguridad acerca de la realización de ciber-patrullaje, bajo la excusa del combate a las pandillas, así como por la detención ilegal efectuada por la Policía Nacional Civil contra Mario Gómez, una de las voces más críticas sobre la implementación del Bitcoin en el país.

Si esta hipótesis se confirma, correspondería en un futuro analizar el proceder de Twitter en la aplicación de sus políticas de moderación de contenidos, a la luz de los estándares de protección de derechos humanos, particularmente respecto al derecho a la libertad de expresión.

A pesar de que el objetivo de esta columna no es corroborar tal hipótesis y, en consecuencia, tampoco lo es ahondar en un análisis sobre el apego a los estándares de derechos humanos, si podemos señalar algunas interrogantes que saltan a primera vista. Valdría la pena preguntarnos: ¿la exclusión de contenidos en Twitter se realiza de manera automatizada?, ¿por qué los spaces son cerrados abruptamente sin explicar al usuario la razón por la que se cierra?, ¿la simple denuncia masiva podría inhabilitar un space o hacer desaparecer un hashtag?, ¿por qué desaparecería con facilidad un hashtag que está ligado directamente con la expresión del descontento con el gobierno que la ciudadanía?

En este caso particular resulta cuestionable afirmar que los spaces y #El15marchamos hayan infringido alguna de las reglas comunitarias de Twitter. En sí ninguna de las expresiones puede ser acusada de circular mensajes de odio, fomentar el terrorismo, o de ejercer violencia u acoso. Si alguna cuenta utilizó el hashtag o participó en algún space contrariando las reglas de la plataforma, deberían ser eliminadas únicamente esas interacciones. De lo contrario, se inhabilita parte de la expresión ciudadana en el marco de un reclamo legítimo a sus gobernantes.

Aunque aún no se ha llegado a medidas extremas como el bloqueo de internet en el país, si la hipótesis se confirma, es pertinente señalar la preocupación respecto a que Twitter inhabilite espacios de discusión política en un momento en el cual debería reforzar su protección. En particular, considerando que afortunadamente la marcha del 15 de septiembre se realizó sin ninguna represión por parte de los cuerpos de seguridad, aunque esto puede cambiar, tal como lo advirtió el presidente Bukele en cadena nacional.

El proyecto de ley para la regulación de las plataformas digitales atenta contra los derechos humanos

La búsqueda de una solución a problemas como la desinformación y la violencia en línea, junto con la necesidad de mayor control sobre las compañías que ofrecen servicios en internet basados en la explotación de los datos personales, son algunos de los desafíos regulatorios más importantes de la actualidad. Son debates que vienen desarrollándose hace varios años, desde distintas perspectivas y en distintos foros, a escala nacional, regional y mundial, por especialistas altamente calificados trabajando desde la academia, la sociedad civil, el sector público y también el privado.

Actualmente no existe consenso sobre cómo abordar estos dilemas regulatorios, pues constituyen problemas altamente complejos, independientes pero enlazados entre sí, con distintas aristas, intereses y derechos que es necesario balancear adecuadamente, cuestión que ha probado ser increíblemente difícil de lograr.

Lo que sí está claro, es que ningún esfuerzo serio por aportar a la solución de estas problemáticas puede pretender resolverlas mediante un proyecto de ley misceláneo, que ignore el trabajo desarrollado por académicos, activistas de derechos humanos y expertos internacionales, así como las obligaciones en materia de derechos humanos. Ninguna de las experiencias comparadas que se destaque a nivel internacional es así, salvo aquella que ha sido producida bajo las lógicas de gobiernos autoritarios con el objetivo de incrementar sus propios mecanismos de control en desmedro de las libertades fundamentales. Y es que los impactos de una mala regulación en la materia puede generar disrupciones graves en la forma en la cual las usuarias interactúan con la tecnología y la forma en la cual se sirven de ella para ejercitar sus derechos.

Y, sin embargo, la propuesta sometida a consideración del Congreso chileno en los últimos días escoge ignorar todo ello en favor de respuestas nóveles que parecen inmunes a la mera consideración de los impactos sistémicos que las responsabilidades civiles propuestas pueden tener sobre derechos fundamentales como la libertad de expresión, el derecho de asociación por medios digitales y la no discriminación, que desde el estallido social y la posterior pandemia se han mostrado como cada vez más fundamentales para el ejercicio democrático a nivel local y global. Junto con ello, el proyecto atropella otros esfuerzos, por ejemplo, la larga lucha por establecer una adecuada protección de datos personales (que se debate hace una década en nuestro país) y es inconsistente con el trabajo que académicos, activistas de derechos humanos y expertos internacionales llevamos desarrollando por al menos una década.

The Chilean way

El pasado 01 de septiembre de 2021 ingresó al congreso nacional chileno el proyecto de ley que regula las plataformas digitales (Boletín N° 14.561-19). La primero que llama la atención es que este proyecto no haya sido resultado de un proceso de trabajo más amplio con la participación de expertos y expertas que contribuyeran a su redacción, considerando que sus patrocinantes son los mismos que en abril de este año convocaron la creación de un grupo de trabajo, al alero de la Comisión “Desafíos del Futuro” del Senado, para debatir muchas de estas cuestiones con expertos de sociedad civil y la academia.

A primera vista, el texto revela defectos formales que hacen sospechar que al proyecto no se le dedicó todo el tiempo debido. Estas sospechas se incrementan tras una lectura detallada de la propuesta, que solo puede ser caracterizada como precipitada y que, en vez de ponerle coto a los potenciales abusos cometidos por las plataformas digitales, tienen un enorme potencial para dañar el ejercicio de derechos fundamentales.

“Consumidores digitales”

En primer lugar, el proyecto define a los usuarios de las plataformas como consumidores digitales. Si el lenguaje crea realidades, esta redacción nos lleva a la tierra de las relaciones de consumo, las que operan bajo una lógica distinta a la de los derechos y libertades esenciales.

El derecho del consumo es una herramienta cada vez más explorada en el contexto internacional para poder abordar algunos de los abusos de los proveedores de servicios digitales, tal es el caso de la Federal Trade Comission de los Estados Unidos o la experiencia regulatoria de la Comisión Europea. Pero en tales casos la regulación se desarrolla en forma incremental y consistente con la actualización de conceptos que provienen de esa área del derecho, y no por el simple hecho de introducir un concepto huérfano y aislado.

Como dio ocasión de atestiguar la tramitación del artículo 15 bis del Boletín Nº 12.409-03 que establece medidas para incentivar la protección de los derechos de los consumidores, hay una oportunidad para que el Servicio Nacional del Consumidor pueda cumplir un rol más activo frente a las plataformas digitales, pero ello debe hacerse con una aproximación sistémica —como la que viene cultivando dicho servicio— y no de espaldas a esos esfuerzos, mediante referencias aisladas en una ley miscelánea como la propuesta.

¿Libertad de expresión digital?

Si hay algo que reconocerle al proyecto es que no escatima en la construcción de conceptos novedosos y torpes. Así, por ejemplo, el texto introduce la noción de “libertad de expresión digital”, que instala una distinción artificial y odiosa entre la libertad de expresión que ocurre «en línea» y fuera de ella.

Cabe recordar que los organismos internacionales de derechos humanos han insistido en que la correcta interpretación que debe guiar la acción de los estados es el reconocimiento de que los mismos derechos en el entorno físico deben ser protegidos en su ejercicio en entornos digitales. Así El Consejo de Derechos Humanos ha recalcado en su resolución sobre Promoción, protección y disfrute de los derechos humanos en internet: “que los mismos derechos que tienen fuera de línea las personas también deben protegerse en línea, en particular la libertad de expresión, lo que es aplicable independientemente de las fronteras y por conducto de cualquier medio de su propia elección, de conformidad con el artículo 19 de la Declaración Universal de Derechos Humanos y del Pacto Internacional de Derechos Civiles y Políticos”.

Ello también ha sido expresamente abordado por la Asamblea General de las Naciones Unidas al exhortar a todos los Estados: “a que velen por que los mismos derechos que tienen las personas cuando no están conectadas, incluidos los derechos a la libertad de expresión, de reunión pacífica y de asociación, estén plenamente protegidos también cuando estén en línea, de conformidad con el derecho de los derechos humanos”.

Como si no fuera suficiente, el artículo que introduce la noción de “libertad de expresión digital” establece que los contenidos publicados por los “consumidores digitales” podrán ser eliminados en caso de que “puedan considerarse civilmente injuriosos, calumniosos, constitutivos de amenazas, que constituyan delitos tipificados por otros cuerpos jurídicos o que inciten a cometer un crimen.” Es decir, la regulación propuesta genera un incentivo absoluto para la eliminación de contenido que pueda ser calificado con el potencial de ser ilícito. ¿Quién califica ese potencial? ¿Quién pondera la libertad de expresión, la privacidad, la no discriminación que pudiera estar en juego?

Una disposición como esta no solo no mejora el panorama actual de deficiencias en la moderación de contenidos que muchas veces se aprecia en plataformas digitales, sino que lo agrava, para entregarles más poder de decisión sobre lo que puede o no expresarse en ellas. En lugar de reducir el poder de las plataformas, lo aumenta.

Valga en este punto y para la regulación posterior contemplada en el mismo artículo, que el artículo 13 de la Convención Americana de Derechos Humanos (CADH), firmada y ratificada por Chile, proscribe la censura previa, así como la censura indirecta, con lo cual parece poco probable que la regulación propuesta resulte compatible con las obligaciones de protección y promoción de la libertad de expresión contraídas por Chile. La CADH permite como límite a la libertad de expresión el establecimiento de responsabilidades ulteriores que pudieran derivarse del ejercicio de ella, pero exige que deben ser fijadas expresamente por ley, cumpliendo además una serie de condiciones (ser necesarias para proteger la reputación de terceros, la seguridad nacional, el orden, salud o moral pública) que no se condicen con las hipótesis propuestas en el proyecto. Ya a corto andar, nos encontramos con un proyecto de ley inconstitucional.

Responsabilidad de las plataformas

Desde la perspectiva de la responsabilidad de las plataformas digitales, el proyecto de ley cierra con broche de oro al establecer un estándar de responsabilidad objetiva y absoluta. Dicho estándar —además de no ser conocido en esta formulación draconiana por ninguna legislación en el planeta— hace aún más severos los impactos en el ejercicio de la libertad de expresión y, a través de ella, de otros derechos fundamentales esenciales para la democracia.

El miedo de que nuestros dichos puedan potencialmente lesionar algún bien o derecho ajeno no solo tendrá un efecto autocensor. Las plataformas digitales, presa de esa misma prevención y para salvar su responsabilidad (objetiva) frente a los daños patrimoniales o morales que ocasionen sus “consumidores digitales”, generarán un patrullaje automatizado de la expresión en línea y que siempre caerá más del lado de la interpretación conservadora para salvar su responsabilidad; es decir, remover cualquier cosa ante el más mínimo atisbo de que pueda resultar problemática. ¿Es esta libertad de expresión desmejorada a lo cual el proyecto de ley quiere bautizar como “libertad de expresión digital”?

El establecimiento de este régimen de responsabilidad objetiva amplísima es, a la vez, una contradicción directa a las recomendaciones de los órganos de derechos humanos a nivel internacional. En el sistema interamericano de derechos humanos, “un esquema de responsabilidad objetiva en el ámbito de la comunicación electrónica o digital es incompatible con estándares mínimos en materia de libertad de expresión”, como ha indicado y reiterado la Relatoría Especial para la Libertad de Expresión de la Comisión Interamericana de Derechos Humanos. Los Principios de Manila, con base directa en el derecho internacional de los derechos humanos, también descartan esa forma de responsabilidad. ¿Por qué el proyecto chileno buscaría posicionarse tan radicalmente en contra del derecho internacional?

El uso de conceptos totalmente abiertos e indeterminados —algunos de ellos con reminiscencias al derecho civil decimonónico— incorporados en el proyecto, tales como “informaciones manifiestamente falsas”, “actuar con diligencia”, “situación actual” o “mecanismos de verificación de edad apropiados”, no hacen más que agravar la incerteza jurídica. Lo más probable es que las plataformas, incapaces de revisar mediante humanos todo el contenido que pasa a través de ellas, lo harán a través de sistemas de inteligencia artificial que, al no distinguir contextos, terminarán bajando contenido perfectamente lícito en forma preventiva, cuestión que ya ha sucedido y ha sido denunciada globalmente por las expertas en la materia.

Por cierto, dejamos de lado por ahora la discusión sobre qué son las plataformas digitales que de acuerdo a la definición del proyecto, que podría ser perfectamente el blog de un centro cultural o comunitario o la infraestructura de comunicación autónoma ofrecida por un grupo feminista o un medio periodístico independiente, todo lo cual es aún más grave para los intereses de las usuarias: prácticamente cualquier servicio digitalizado conllevaría obligaciones de monitoreo y control.

El proyecto además concede al Estado el poder para ordenar la suspensión de plataformas, lo cual contraviene las recomendaciones de los organismos de protección de derechos humanos para asegurar y promover una internet libre y abierta. No hay duda sobre la falta de legitimidad democrática y desproporción de este tipo de medidas, como se lee claramente en la declaración conjunta de los Relatores Especiales de las Naciones Unidas y de la CIDH para la Protección y Promoción del Derecho a la Libertad de Opinión y de Expresión de 2015: “El filtro de contenidos en Internet, el uso de ‘interruptores de apagado de emergencia’ en las comunicaciones (por ejemplo, el cierre de partes enteras de los sistemas de comunicación), y la apropiación física de las estaciones de radiodifusión son medidas que nunca pueden ser justificadas”.

Podríamos seguir uno a uno con los artículos del proyecto explicando sus insuficiencias e incompatibilidad con la protección de derechos fundamentales, pero creemos que ya ha quedado claro que estamos frente a un proyecto técnicamente deficiente, inmaduro en dar cuenta del estado del arte de los debates internacionales en la materia y formulado de espalda a la protección de derechos fundamentales y al abordaje sistémico que ellos requieren.

Seguramente hay buenas intenciones detrás. pero llamamos a una reflexión profunda acerca de la forma más sensible de tener este debate en forma participativa y abierta, para recoger las experiencias internacionales en la materia y los aportes que expertos tanto de sociedad civil, como la academia puedan hacer desde distintas disciplinas, para poder tener una discusión a la altura de lo que la complejidad de a temática requiere, sin pausas pero sin prisas que generen impactos negativos sistémicos en el ejercicio de derechos fundamentales en el entorno digital. No por nada, fuera de Chile este tema lleva siendo discutido en la última década, no reinventemos la rueda cuadrada.

¿Es la censura de contenidos una protección efectiva para la niñez y la adolescencia?

La discusión en Colombia de un proyecto de ley para la protección de niños, niñas y adolescentes es otro capítulo de intentos desmedidos por proteger derechos amenazando internet.

El proyecto de ley 600 de 2021 fue presentado por el Ministerio de Tecnologías de la Información y las Comunicaciones y aprobado en primer debate en comisión de la Cámara de Representantes de Colombia. Declara tener por objeto la regulación de las responsabilidades especiales de los medios de comunicación frente a los derechos de la niñez, la infancia y la adolescencia. Como se ha reiterado en varias ocasiones, se trata de una deuda del Estado colombiano con la implementación de una orden de su Corte Constitucional.

El PL 600 propone la adopción de mecanismos destinados a prevenir la producción y difusión de contenidos que atenten contra los derechos de NNA, tanto en medios de comunicación masiva como en internet. Establece un conjunto de obligaciones para los medios, además de un régimen sancionatorio aplicable en caso de materializarse un presunto comportamiento reprochable respecto de cualquiera de las medidas incorporadas al ordenamiento a través del referido proyecto de ley.

Aunque en principio el objetivo sea loable, es necesario hacer un acercamiento al contenido de tal normativa, con el fin de evaluar si en el afán de alcanzar el objetivo declarado no se están poniendo en riesgo derechos fundamentales de terceros, que ya han sido advertidos.

El contenido preocupante del PL 600

En el capítulo IV el proyecto crearía una comisión de expertos, compuesta por personas de distinta índole y pericias, entre cuyas funciones está la de proponer “iniciativas técnicas y administrativas sobre sistemas o mecanismos de detección, control parental, filtro y clasificación de contenidos”. Para ello, se elaborará un catálogo de contenidos “que pueden atentar contra la integridad psíquica, física de la niñez o adolescencia o derechos preestablecidos en la Constitución y ley, mediante el acceso, uso y aprovechamiento del internet” (Art. 13).

A los proveedores de servicios de internet (PSI), pobremente definidos en la ley para cubrir desde conexión hasta plataformas en línea, les aplican las disposiciones referentes a “Deberes” y “Medidas Técnicas” que deben cumplir, que incluyen el bloqueo y filtrado de contenidos (Art. 15.4 y 16.2) bajo la amenaza de incurrir en infracciones y recibir las sanciones descritas en el Capítulo V. Esta disposición traslada a los PSI la responsabilidad por el contenido de terceros que sea considerado infractor, lo que a la larga constituye una forma de censura previa.

Todas estas disposiciones resultan problemáticas ya que chocan con el derecho a la libertad de expresión, pues dichos artículos limitan contenidos sin estar en armonía con las condiciones establecidas en la Convención Americana sobre Derechos Humanos. Atentan a la vez con el principio de neutralidad de la red, por pretender la imposición de barreras a la libre circulación de expresiones en línea; afectan también a la garantía del debido proceso, por establecer una medida restrictiva de derechos fundamentales, como es el bloqueo de contenido, sin proceso previo ni orden judicial.

Nuevos riesgos para la libertad de expresión en línea

Tal como miembros de la academia, el sector privado y la sociedad civil han hecho ver en reuniones cerradas y audiencias públicas frente al Ministerio TIC y el Congreso de Colombia, un derecho especialmente afectado es la libertad de expresión, en los términos del Art. 20 de la Constitución de Colombia y el Art. 13 de la Convención Americana sobre Derechos Humanos, incluyendo a la libertad de buscar, recibir y difundir informaciones e ideas de toda índole. Como sabemos, no es un derecho absoluto y está sujeto a limitaciones.

La jurisprudencia interamericana desarrolló un test para fijar ese marco de limitaciones legítimas, que deben cumplirse todas: 1) haber sido definida en forma precisa y clara a través de una ley formal y material; 2) estar orientada al logro de objetivos imperiosos autorizados por la Convención; y 3) debe ser necesaria en una sociedad democrática para el logro de los fines imperiosos que se buscan; estrictamente proporcionada a la finalidad perseguida.

Dentro de ese marco, aquellas disposiciones del PL 600 que establecen bloqueos y filtro de contenidos representan la implementación de mecanismos de censura previa, prohibido por la Convención Americana, en tanto constituyen medidas de control preventivo y no responsabilidades posteriores a quienes abusen de ese derecho. Además, se trata un mecanismo amplio, no restringido a las hipótesis de limitaciones legítimas, como cuando se trata de contenidos abiertamente ilícitos y aquellos discursos que no están resguardados bajo la protección del derecho a la libertad de expresión, como la propaganda de la guerra y la apología del odio, la incitación directa y pública al genocidio, y el contenido de explotación sexual a NNA.

Incluso si el PL 600 estableciera solo responsabilidades ulteriores, habría que analizar si las limitaciones a este derecho cumplen con el test mencionado. En este caso, pueden señalarse dos puntos que resultan problemáticos para cumplir con el primer requisito. Por un lado, las causas para limitar contenidos que se encuentran en forma de catálogo, son ambiguas y podrían permitir una interpretación arbitraria de la autoridad, incumpliendo el paso de legalidad estricta del test (Art. 13 del PL 600). Por otro lado, está sujeto a sanciones que, además de afectar a intermediarios de comunicaciones, condiciona su acción y traslada a ellos responsabilidad por el ejercicio de la censura.

Sobre el cumplimiento del requisito de necesidad dentro del test tripartito, no puede asegurarse que las disposiciones del PL 600 tengan por fin cualquiera de los objetivos enumerados que ha desarrollado la jurisprudencia interamericana. Tampoco puede señalarse que las disposiciones que pretenden bloquear o filtrar contenidos contra la integridad psíquica, física de NNA o sus derechos preestablecidos en la Constitución y ley, sean necesarios, idóneos y proporcionales, ni siquiera para ese fin.

¿Qué va a pasar con el PL 600?

La iniciativa parece estar interrumpida debido al escándalo por irregularidades contractuales que hoy envuelve al Ministerio TIC, lo que resta su peso en impulsar proyectos como el PL 600.

Esperamos que el debate sobre la conveniencia de proyectos de ley que apunten a la protección de los derechos de NNA continúe y se profundice, no sólo en Colombia sino a nivel regional. La finalidad es obtener mejores insumos que permitan una normativa respetuosa de los derechos fundamentales, sin buscar soluciones en la restricción de la circulación de contenidos en internet.

Este caso un comienzo de una conversación que nos desafía para el genuino resguardo de todos los derechos de las nuevas generaciones de internautas.

Memes para sobrevivir el apocalipsis

Desafíos desde la propiedad intelectual para el tratamiento de obras derivadas digitales en América Latina.

La naturaleza de los memes, conjuntamente con la casi absoluta imposibilidad de determinar una autoría en el proceso masivo de su creación y difusión, hacen que la persecución de este contenido haya sido muy mínima. Sin embargo, con las legislaciones sobre copyright y los procesos de automatización esto puede cambiar.

Vivir internet siendo queer: Autoexpresión, comunidad y problemáticas

En un grupo de Facebook cerrado alguien escribe para consultar por dudas legales. Cuenta que quiere cambiarse el nombre registral y que le gustaría acceder a una mastectomía. Comenta que se siente cómode con pronombres femeninos y masculinos, pero plantea lo siguiente: “¿Algune lo ha hecho siendo no binarie? ¿Cómo ha solucionado el tema con su nombre?”. Les participantes del grupo dan consejos amables.

Este tipo de situaciones se replica en otras redes, es un intercambio que ocurre en algunos barrios de TikTok cuando alguien muestra un binder –prenda de ropa interior usada para comprimir el pecho–, y en los comentarios se leen recomendaciones de cómo usarlos y dónde conseguirlos. A pesar de que internet es un espacio en que la comunidad LGBTQIA+ puede apoyarse para construir confianzas (a veces complejas de emular en el mundo físico), la estructura de los servicios web, es limitada porque no considera una diversidad más allá de lo binario y reproducen problemas de la vida offline. Tanto al llenar formularios de inscripción en las que se consideran género masculino o femenino únicamente, o al intentar editar tu nombre visible, entre otras.

Antes de reconocerme como una persona queer, sentía miedo de ser aceptada. Primero por mi familia, entre mis amigues, en mi trabajo y de igual modo en internet. ¿He sentido miedo de exponer que me identifico como parte de las disidencias sexuales y de género en redes sociales? Sí. ¿He temido por mi seguridad en la vía pública por expresar mi orientación de género o por manifestar mi sexualidad de forma libre? Sí. Con el paso del tiempo, aprendí a desenvolverme con más confianza, porque existo todo el año (no solo en junio) y estoy orgullosa de amar y ser amada.

Una vez que se toma conciencia de la interseccionalidad de las problemáticas que aquejan a la comunidad LGBTQIA+, es posible entender que el mundo online no está exento de una mirada heterocispatriacal, donde en términos género prima lo masculino y lo femenino, pero también la heteronorma obviando otras identidades. Lo vemos en las grandes compañías de servicios de internet, que acaparan la mayor cantidad de tráfico, como Facebook, Google y terminan dominando las interfaces y algoritmos de los dispositivos que excluyen otras experiencias.

Entonces, ¿qué podemos exigir a las tecnologías para visibilizar, incluir y proteger las experiencias de la comunidad LGBTQIA+? ¿qué problemáticas, riesgos, amenazas, existen? y ¿qué posibilidades ofrece internet para nuestras vivencias? Estas son algunas reflexiones.

Búsqueda de espacios seguros

Según un estudio de discriminación y violencia hacia personas LGBTQIA+ (2020) de la Dirección de Estudios Sociales (DESUC) para la Subsecretaria de Prevención del Delito de Chile, un 89% de les encuestades dijo haber sufrido algún tipo de discriminación en su vida. Más de un 38% de les encuestades ha sido víctima de algún “delito cibernético, como hostigamiento por redes sociales”, y más de un 22% declaró que este tipo de vulneraciones habría ocurrido en el último año.

En un intento por averiguar la visión de mis seguidores en Instagram, hice una encuesta a través de historias para conversar acerca de la forma en que las personas queer habitamos internet. Spoiler: la vida online no difiere mucho de la vida offline.

A pesar de las posibilidades de conectarnos y construir espacios seguros, hay quienes se enfrentan a violencias en el entorno digital, como acoso digital, doxing, la proliferación de discursos transodiantes, descalificaciones por lesbodio o biodio, cuestionamientos y ataques a la visibilidad a diario. En este contexto, es pertinente citar el estudio de la Agrupación Lésbica Rompiendo el Silencio, tras la agresión que sufrió Carolina Torres en Chile en 2019. En el caso de Estados Unidos, esta temática se advierte en el Índice de seguridad en redes sociales de la Alianza de Gays y Lesbianas contra la difamación (GLAAD). Es por eso que es relevante exigir la urgencia de la moderación de contenidos en las plataformas digitales, para combatir ejércitos de trolls, evitar que proliferen discursos odiantes, que se siembre la desinformación, o la viralización de mitos en torno a las disidencias.

Al momento de configurar las biografías de Twitter, Instagram, aplicaciones de citas o plataformas, incluir o no el emoji de la banderita LGBTQIA+, compartir fotos o usar ciertos hashtags puede involucrar lidiar con ansiedades debido a la exposición. En ocasiones, es una forma de autoexpresión, una reafirmación y, así mismo, una forma de encontrarse, pero también un riesgo que muches no quieren correr. Si bien la visibilidad puede ser una opción, pero no una obligación como pretenden las plataformas web. Es necesario entender el derecho al anonimato como una forma de tener control sobre esa visibilidad.

Entre los testimonios que recopilé (en su mayoría identidades lésbicas, no binarias y bisexuales), hubo una lesbiana que dijo que tras googlear “lesbiana”, la llevaron a una psicóloga para que se rehabilitara. Según su relato, encontrar espacios en internet antes de 2008 era complicado, pero logró dar con un foro en el conoció a sus primeras parejas. Otra persona, cuyos pronombres son ella/elle, aseguró que cuando era niña todas las actividades las realizaba en soledad. Escuchaba programas de radios gays a escondidas, antes que existieran los podcasts. “Ahora se pueden hacer redes de una forma muy sencilla y bonita. Es fácil encontrar a alguien que esté pasando por lo que tú, nunca estás sola”, escribió. Alguien bisexual comentó que se siente fuera del closet con amigues, en su entorno laboral, pero que no así con su familia. Aunque cree que en los últimos años gracias a infografías en Instagram, ahora hay más bi-visibilidad.

Otras problemáticas

Cuando hablamos de internet, las brechas de acceso y conectividad son una clara barrera. De acuerdo a cifras de la Alliance for Affordable Internet, a nivel mundial cerca de 4 mil millones de personas no cuentan con conexión. La dificultad para mantenerse conectade en algunas latitudes se suma a bloqueos de internet, a censura y respuestas desde violencias a multas por difusión de contenido LGBTQIA+ .

Así como hablamos de identidad y representación, también vale la pena mencionar otros obstáculos que tienden a la exclusión, relacionados al abordaje de políticas públicas. Así se documenta en “Sistemas de identificación y protección social en Venezuela y Bolivia: Impactos de género y otras formas de discriminación”. Este reporte de Derechos Digitales, plantea cómo los sistemas biométricos afectan de forma directa a mujeres y población LGBTQIA+, familias homoparentales y en mayor medida a personas transgénero. No solo en cuanto a derechos a la identidad, a la privacidad de datos, si no también afecta directamente el acceso a ítems de desarrollo social como el acceso a la alimentación, la salud, la integridad y la dignidad, entre otros.

No es un secreto que en lo que respecta al uso de tecnologías de reconocimiento facial, las que se vuelven más cada vez más cotidianas, solemos tenerlas a mano, pero también se utilizan a nivel de gobiernos e incluso en aeropuertos. El principal problema es que se construyen en base a sesgos de diseño, que discriminan a la población no hegemónica y entran en conflicto aspectos como género y raza, según reportes de Coding Rights en Latinoamérica.

En un mundo en que cada vez más la tecnología determina cómo se organiza la sociedad, los sesgos en los sistemas como tecnologías automatizadas, inteligencia artificial, o en base a algoritmos, moldean y disciplinan las identidades a partir de los cuerpos. Esto determina qué corporalidades están permitidas, y cuáles no, dejando fuera a personas trans, o no binarias. Así, la forma de subvertir las estructuras vigentes, es cambiarlo todo, o en palabras de Audre Lorde: “las herramientas del amo nunca desmantelarán la casa del amo”. Desde ahí, la concepción del diseño es la clave para abolir las desigualdades entre grupos excluidos, con el objetivo de co-crear herramientas y prácticas de transformación social, tal como explica Sasha Costanza-Chock en Design Justice.

Ante las diversas problemáticas vigentes, el escenario se vuelve complejo y desesperanzador. Pero a pesar de los obstáculos, decido creer en un futuro más auspicioso, que se construirá únicamente de la mano de una perspectiva feminista interseccional, que busque hackear los parámetros que limitan las posibilidades de ser de las personas.

Para ello, es vital construir espacios seguros, en el mundo online y en el offline, que nos permitan aprender y encontrarnos. Identificando problemas, documentando violencias, visibilizando nuestras vivencias y liderando conversaciones, a fin de descolonizar el impacto de las estructuras que han sido gestadas desde la mirada del hombre blanco y heterocis.

¿Se han violado los derechos humanos en internet en Colombia? Necesitamos explorar esa posibilidad

Desde el pasado 14 de mayo, y a partir de las denuncias sobre presuntas violaciones a los derechos humanos en el marco de las protestas que se desarrollan a nivel nacional desde el 28 de abril, la CIDH solicitó al gobierno colombiano una visita urgente de verificación, la cual fue reiterada el 25 de mayo luego de que el gobierno propusiera hacerla después de la audiencia programada para el 29 de junio.

La visita será la próxima semana y no incluye en su agenda la revisión de afectaciones a los derechos humanos utilizando herramientas tecnológicas y en el ámbito digital. Por eso, la Fundación Karisma con apoyo de otras organizaciones locales ha enviado una carta a la CIDH, pidiendo que se incluyan estos temas durante las jornadas de verificación.

Incidentes en la red

El 28 de abril estallaron en Colombia una serie de protestas, primero contra el proyecto de reforma tributaria propuesto por el gobierno, pero también contra el proyecto de reforma a la salud y la crisis generalizada de derechos humanos, que durante la pandemia se ha intensificado. Las protestas se han mantenido por más de un mes y han convocado a los más diversos sectores sociales.

Desde el primer día de protestas las redes sociales se llenaron de denuncias sobre abuso de la fuerza, uso de armas no convencionales y de fuego por parte del Escuadrón Móvil Antidisturbios (ESMAD) de la Policía Nacional, y también sobre bloqueos de contenido y de cuentas que estaban haciendo estas denuncias en plataformas como Instagram, Facebook y Twitter. En aquel entonces, por unas horas, el sistema de tendencias en Twitter dejó de funcionar, lo que fue percibido como un acto de censura, aunque luego se reportó una falla técnica en varios países.

Además, el 6 de mayo muchas personas empezaron a reportar que las historias en Instagram relacionadas con #ParoNacional desaparecían. A las pocas horas, la plataforma informó que se trataba de una situación global y generalizada, no relacionado con algún tema en particular.

Una vez solucionado el problema, que afectó los destacados, historias y archivos de la plataforma, especialmente los contenidos compartidos, Instagram nuevamente comunicó que los reportes provenían principalmente de Colombia, comunidades indígenas en Estados Unidos y Canadá, y Palestina. Sin embargo, los lugares con mayor afectación fueron Estados Unidos y Brasil. Como manifestó Carolina Botero, directora de Karisma, la explicación de Instagram requiere mayor análisis dada la afectación particular sobre poblaciones que se encontraban en crisis sociopolítica por esos días.

Por otra parte, el 3 de mayo en la ciudad de Cali se transmitió en vivo el asesinato de un manifestante; esa misma noche, se denunció la muerte de al menos tres personas en el sector de Siloé, al occidente de la ciudad. En medio de la tensión, la noche del 4 de mayo muchas organizaciones de derechos humanos y medios alternativos denunciaron en redes que en los puntos de concentración en Cali (especialmente en Siloé) se estaba bloqueando completamente la conexión a internet, mientras la policía atacaba a les manifestantes.

En la mañana del 5 de mayo, Netblocks publicó un reporte que confirmaba la interrupción parcial del servicio en Cali. En respuesta a las denuncias, tanto el Ministerio TIC, como la Comisión de Regulación de Comunicaciones (CRC) y las empresas EMCALI y Movistar, emitieron comunicados donde se concluyó que sí hubo fallas técnicas en el servicio de internet fijo debidas al robo de un cable, y que por la situación de orden público no fue posible repararlas de inmediato; pero definitivamente “no hubo una interrupción deliberada del servicio”.

Esta conclusión, que corresponde con el reporte técnico, abrió otras interrogantes, dado que las denuncias de desconexión se estaban haciendo desde un sector al occidente de Cali y principalmente en internet móvil, mientras que el daño técnico se reportó al oriente de la misma ciudad, afectando principalmente conexiones fijas.

De acuerdo con Carolina Botero, si bien es posible que la red se haya saturado esa noche, también se podrían estar utilizando inhibidores de señal, los cuales están prohibidos en todo el territorio nacional, excepto para organismos de seguridad del Estado, quienes podrían utilizarlos sin autorización del Ministerio TIC, en casos relacionados con la seguridad pública. Además, también se denunció el uso de estos inhibidores el 12 de mayo, en los alrededores del Estadio Romelio Martínez de la ciudad de Barranquilla, donde se jugaba un partido de fútbol en medio de las protestas.

Teniendo en cuenta los cuestionamientos sobre la autonomía de la CRC y su falta de incidencia sobre la gestión del espectro, desde hace tiempo Karisma ha insistido en la necesidad de que existan mecanismos transparentes para regular y escrutar, no solo al sector privado, sino también al sector público. Esto se evidencia en la denuncia sobre el bloqueo de los dominios archive.org y ghostbin.co por parte de las empresas EMCALI y Avantel, en respuesta a una resolución expedida por la Superintendencia de Industria y Comercio, y vigilada por el Ministerio TIC.

Como también señaló Karisma, esta resolución podría ser legítima, pero desconoce el funcionamiento de internet y la imposibilidad de bloquear solamente una URL, lo que la hace completamente desproporcionada. Vale decir que la resolución surge en respuesta al filtrado de datos personales de altos mandos militares, realizado por Anonymous como forma de protesta el 4 de mayo.

Estas acciones, cuya legitimidad no es tema de discusión aquí, junto a otras como el saboteo a ciertos hashtag por parte de K-poppers, han servido al gobierno para alimentar una campaña de estigmatización a la protesta digital que, a través de lo que el Ministerio de Defensa ha denominado “ciberpatrullajes”, amenaza a libertad de expresión, según ha señalado la Fundación para la Libertad de Prensa (FLIP).

Este panorama es especialmente preocupante si recordamos las “medidas preventivas” desplegadas en Colombia previo a las manifestaciones del 21N de 2019, que supuestamente incluían la adecuación de aeronaves con sofisticados sistemas de reconocimiento facial, sobre los cuales no hemos tenido noticias durante estas jornadas de protesta.

Preocupante además, porque luego del escándalo sobre perfilamiento a periodistas, activistas y opositores al gobierno por parte del Ejército Nacional a principios de 2020, se denunció que la Policía planeaba comprar un sistema completo de “ciberinteligencia” por alrededor de un millón de dólares. Si bien esta compra fue cancelada, Karisma analizó sus características técnicas, que incluían no solo la capacidad de analizar información sino de infiltrarse en actividades a través de medios digitales.

Esperamos que la CIDH atienda al llamado que hacen las organizaciones locales en Colombia y que apoyamos en América Latina, para reconocer las graves afectaciones a los derechos humanos en el entorno digital durante las protestas en Colombia, que hoy cumplen 38 días consecutivos.

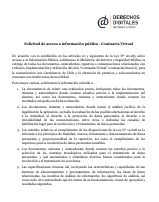

Solicitud de acceso a información pública – Comisaría Virtual (2021)

La persecución de Ola Bini: ¿el inicio del fin?

Hace casi dos años, cuando no había ni pandemia ni contagios por un nuevo y letal coronavirus, cuando varios países de la región parecían no ver venir protestas masivas en las calles, Ola Bini fue arrestado en Ecuador. Fue puesto en prisión por diez semanas y sus equipos tecnológicos fueron incautados, en busca de evidencia de los delitos que supuestamente justificaban el arresto. Casi dos años después, sin todavía lograr la libertad.

Recapitulando: el activista y desarrollador de origen sueco Ola Bini fue detenido en abril de 2019 en Ecuador, por su supuesta participación en una red de espionaje digital para desestabilizar al gobierno ecuatoriano. El arresto ocurrió muy poco después de la expulsión de Julian Assange de la embajada ecuatoriana en Londres, y después de que la ministra del interior alertara sobre intentos de «desestabilización del gobierno» por «hackers rusos» y gente afiliada a Wikileaks. Ataque del que aún no se conocen más antecedentes más allá de ese mismo anuncio.

Los (entonces) relatores especiales para la libertad de expresión de la ONU y de la CIDH solicitaron información desde el gobierno ecuatoriano, pero la persecución no cesó. Como hemos denunciado junto a otras organizaciones desde 2019, existe una serie de situaciones alarmantes en torno al arresto y la detención de Bini, siendo la más relevante la insistencia en la persecución penal en su contra, a pesar de la notoria falta de justificación suficiente. Es decir, no existen antecedentes suficientes ni para la inicial acusación de ser parte de una red de espionaje digital, ni de otras de “defraudación fiscal” o “tráfico de influencias”, manteniéndose hasta hoy una investigación con características de persecución política.

Una oportunidad de poner fin a las alegaciones surgió en diciembre de 2020, en una audiencia preparatoria al juicio por «acceso no consentido» a un sistema informático, con una única captura de pantalla. Sin embargo, tampoco ahí terminó la persecución. Es más, organizaciones como la Electronic Frontier Foundation y Amnistía Internacional fueron impedidas de participar como observadoras en la audiencia. El esfuerzo de la defensa por demostrar la violación de los derechos de Bini durante la investigación, en una exposición de cuatro horas de su abogado, tampoco fue suficiente en esa ocasión. El proceso fue así validado para continuar y la audiencia fue suspendida otra vez antes de la decisión de comenzar el juicio propiamente tal.

A la espera de que la audiencia se retome, para continuar la preparación hacia un juicio y la evidencia admisible, nuestra preocupación por el caso sigue vigente. Porque no está en juego solamente la situación judicial de una persona, sino la noción misma de debido proceso. Está en juego la confianza en los procesos institucionalizados para determinar con imparcialidad. Y, mirando con cuidado a antecedentes con componentes técnicos complejos, si es que hay sustento para la persecución de una persona, por encima de cualquier presión política. Está en juego la superación de los discursos que asocian la seguridad digital a la sospecha y la criminalidad. Está en juego el ejercicio de los derechos fundamentales en línea, incluidos no solo la privacidad y la libertad de expresión, sino también la investigación de seguridad y la promoción de herramientas de protección de comunicaciones y dispositivos. Seguimos observando el caso, porque queremos que liberen a Ola Bini.

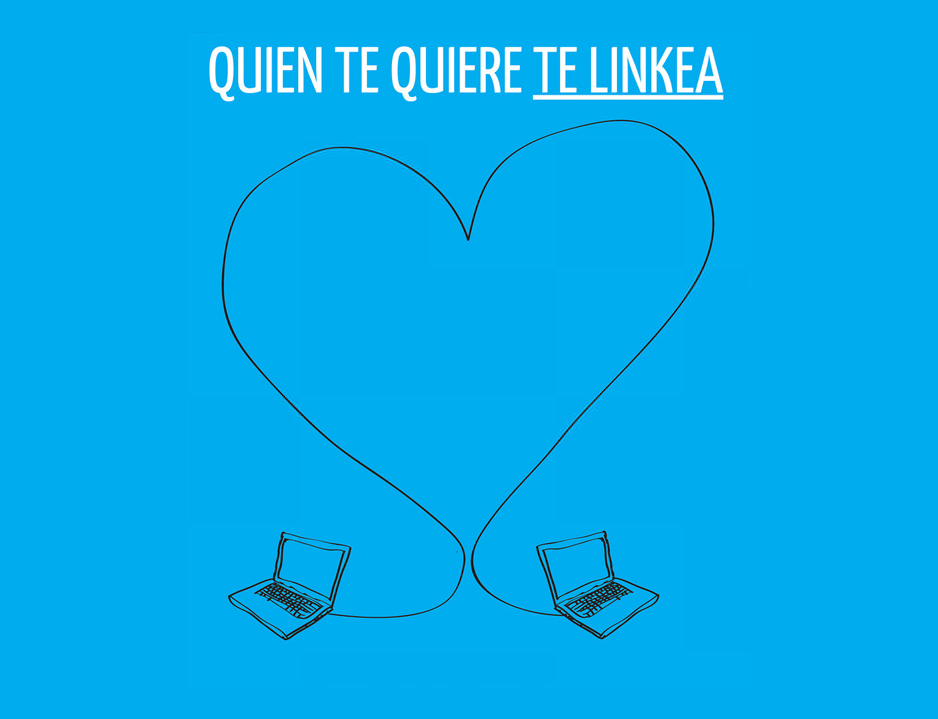

Pagar por enlazar

Esta semana, Australia aprobó una ley que exige a las plataformas digitales —como Facebook y Google— pagar a los medios de comunicación locales para enlazar su contenido en los feeds de noticias o en los resultados de búsqueda. Según ha declarado el Ministro de Comunicaciones australiano, la ley tiene por finalidad asegurar que los medios de comunicación sean remunerados de manera justa por el contenido que generan y proteger la sustentabilidad del negocio.

Antes de la aprobación de la ley, y como respuesta a la propuesta, Facebook había bloqueado todo el contenido noticioso en Australia, al mismo tiempo que Google amenazó con remover su motor de búsqueda en el país. Una amenaza que no llegó a concretarse, en la medida en que Google ha ido cerrando acuerdos comerciales con diferentes empresas de medios, tal como está pautado en la nueva ley. En caso de no alcanzar dichos acuerdos, el costo del enlace será decidido por un árbitro

La iniciativa australiana no es la primera que apunta en este sentido. En España, el canon AEDE, también conocido como la “tasa Google”, surgió de la exigencia de los medios de comunicación de que Google les pagara por enlazar y culminó con el cierre de Google News España en 2018. De tal modo, el canon AEDE, aunque aprobado, nunca fue desarrollado en reglamento ni aplicado. No obstante, el viraje de timón es claro: en 2020, Google anunció “un programa de licencias para apoyar a la industria de las noticias”, con acuerdos cerrados para Alemania, Australia y Brasil y, más recientemente, con Francia. Este nuevo impulso podría, sin duda, sentar un precedente para la forma en que otros países regulan las tecnologías. Así, países como Canadá y el Reino Unido están considerando las posibilidades de regulación. En Chile, el senador Guido Girardi anunció que presentará un proyecto de ley para forzar a compañías como Google y Facebook, a pagar por tener o compartir “datos y contenidos digitales”.

Independiente de que las leyes sean aprobadas y los acuerdos alcanzados, las críticas originales que generó el canon AEDE siguen vigentes: por un lado, la capacidad de enlazar a contenido es la base misma de la existencia de la red: una red donde no es posible enlazar deja de ser una red para convertirse en fragmentos aislados de información dispersa.

Por otro lado, la inclusión de fragmentos o resúmenes de noticias en los motores de búsqueda y en los feeds de noticias es una actividad protegida por el derecho de cita. En un ímpetu por regular conductas desde la necesidad comercial, los medios de comunicación parecen olvidar cómo podrían estar perjudicándose a sí mismos, en el contexto de un ecosistema en el que los usuarios ya no acuden directamente al medio, sino que obtienen sus noticias mediante las redes sociales que son, en la práctica, la puerta principal del tráfico a los medios.

Un ecosistema de noticias donde la sobreabundancia de información es un problema real, donde los medios han perdido la confianza de los usuarios, y donde los usuarios dependen de terceros o de las propias plataformas para que le sirvan de curadores de contenido, tiene problemas mucho más serios que no pueden resolverse con la fijación de pagos obligatorios, que están destinados a mantener vivo el ecosistema actual, no a resolver sus problemas. En mi pueblo, eso se llama “correr la arruga”, y no ha funcionado jamás.