Palabras como “bot”, “algoritmo” e “inteligencia artificial” se han vuelto parte de nuestro lenguaje cotidiano. A pesar de que muchas veces no tenemos del todo claro qué significan, aluden a un imaginario de total automatización, sistemas súper inteligentes capaces de tomar mejores decisiones, más rápido, sin sesgos, basadas en el análisis de grandes volúmenes de datos.

Sin embargo, la realidad está muy lejos. Y cuando hablamos de la moderación de contenidos en redes sociales son necesarias personas que trabajan como “escudos humanos de internet”, dedicadas a leer, escuchar y mirar todo lo que el resto del mundo no quiere ver.

La moderación de contenidos es un trabajo esencial en las redes sociales y tiene como función mantener los contenidos de las plataformas en un mínimo aceptable tanto para asegurar la experiencia de las comunidades de usuarias y usuarios, como para incentivar la inversión publicitaria. En 2021, los ingresos de compañías como Meta y TikTok superaron los 50.000 millones de euros, un negocio que solo es posible gracias a la moderación de contenidos.

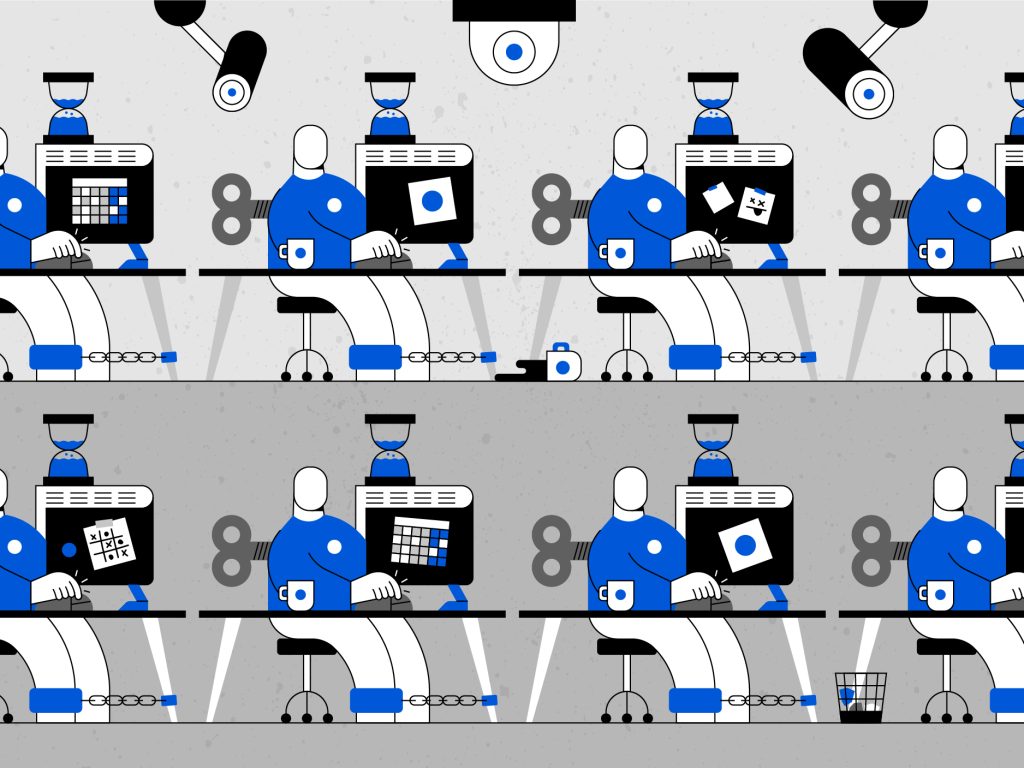

Se trata de un trabajo que, en gran medida, se hace de forma manual: equipos de personas buscando y marcando textos, imágenes y audios inapropiados; clasificación que, a su vez, se utiliza para entrenar sistemas automatizados. Es decir, la capacidad de un algoritmo para identificar contenido nocivo descansa en trabajo humano. Cada vez que un contenido es retirado de una plataforma, este ha sido visto y marcado por un moderador de contenido humano o un sistema automatizado entrenado con datos proporcionados por un humano.

En general, se trata de un mal trabajo. En su libro GhostWork: How to Stop Silicon Valley from Building a New Global Underclass (Trabajo fantasma: cómo evitar que Silicon Valley construya una nueva subclase global) la antropóloga Mary L. Gray y el científico social Siddharth Suri analizan particularmente el rol de los etiquetadores de datos y moderadores de contenido.

Diariamente, el 98% de los contenidos violentos son retirados de las plataformas por humanos. Quienes realizan estas tareas están sujetas a múltiples riesgos, incluyendo daño psicológico, producto tanto del tipo de contenidos al que están expuestas —asesinatos, suicidios, pedofilia, accidentes y hasta canibalismo, lo peor de internet— y condiciones laborales precarias: vigilancia laboral extrema y jornadas extenuantes, en un trabajo de corta permanencia y alta rotación que no provee la atención psicológica necesaria. Algunas de las consecuencias que se han identificado son son síntomas de ansiedad, depresión y trastorno de estrés postraumático.

Además, es común que las compañías contraten empleados a través de empresas tercerizadas, lo que dificulta la sindicalización y la posibilidad de rechazar prácticas poco éticas o exigir mejores condiciones de trabajo.

Recientemente en Colombia, donde se encuentra uno de los principales centros de moderación de contenidos de TikTok en América Latina (el otro es Brasil), un grupo de empleados denunció sus condiciones laborales, que implican jornadas de 10 a 12 horas, 6 días a la semana, por un salario que apenas supera el mínimo. A cambio, deben analizar más de 1.200 vídeos cortos por turno, con escasos para tomar una decisión respecto a si el contenido viola o no las normas de la plataforma.

Además, deben mantener su cámara encendida durante todo el turno, para asegurar que nadie más vea el contenido, y su escritorio debe permanecer vacío, con excepción de un vaso transparente con líquido.

Mientras nos enteramos que una red social se vende por sumas exorbitantes y escuchamos sobre los miles de trabajadores despedidos en otra, es mandatorio que reflexionemos sobre el trabajo de las personas que permiten el funcionamiento de las plataformas, quienes aportan la materia prima sobre la cual se sustenta el negocio.

Salarios justos, beneficios laborales, entrenamiento, condiciones mínimas de seguridad y apoyo psicológico a quienes se enfrentan a contenidos que luego serán vetados debería ser una condición irrenunciable para quienes aspiramos a habitar espacios virtuales más democráticos y humanos.

Ecuador

Ecuador Redes Sociales

Redes Sociales ¿A dónde vamos?

¿A dónde vamos?